… for you

As yet but knock, breathe, shine, and seek to mend;

That I may rise and stand, o’erthrow me, and bend

Your force to break, blow, burn, and make me new.

I, like an usurp’d town to another due,

Labor to admit you, but oh, to no end;

Reason, your viceroy in me, me should defend,

But is captiv’d, and proves weak or untrue.

Yet dearly I love you, and would be lov’d fain,

But am betroth’d unto your enemy;

Divorce me, untie or break that knot again,

Take me to you, imprison me, for I,

Except you enthrall me, never shall be free,

Nor ever chaste, except you ravish me.

„Holy Sonnet XIV„, John Donne

Ich hatte da noch was offen:

[…] kann das zentrale Thema sehr stark vereinfacht, aber nicht unzulaessig, als „die Angst der Wissenschaftler die Atmosphaere zu entzuenden“ zusammengefasst werden. […] ich diskutiere das vielleicht nochmal genauer an anderer Stelle.

Der vorliegende Artikel ist besagte „andere Stelle“ und zum Glueck ist dies der diesjaehrige: Geburtstagsbeitrag! Wie immer erlaube ich mir so viel zu schreiben wie ich Lust habe, ohne den Artikel in mehrere Teile zu spalten … denn bei dem Thema brauche ich den Platz fuer den Versuch die Komplexitaet des Themas zumindest anzureiszen.

Los geht’s mit der fuer mich wichtigsten Szene im Film, in der Isidor Rabi Los Alamos (mich duenkt) das erste Mal besucht. Dort findet er Oppenheimer in Uniform vor, was Rabi sofort als unecht erkennt, und erzaehlt ihm am Ende:

Be yourself, only better.

Aber das ist nur die Szene an sich. Fuer mich wichtig … mir kamen fast die Traenen, (auch beim wiederholten Schauen) weil’s mir so nahe ans Herz ging … ist die Stelle in der Oppenheimer seinem (besten?) Freund anbietet die Theoriesektion des Manhatten Projekts zu uebernehmen. Rabi erwidert dann (Seite 60) emotional sehr mitgenommen:

You drop a bomb and it falls on the just and the unjust. I don’t wish the culmination of three centuries of physics to be a weapon of mass destruction.

Der zweite Satz ist der Teil, der mir so sehr nahe geht. Meine geliebte Wissenschaft (nicht nur Physik) deren Ergebnisse leider direkt und indirekt zum Tøten von Menschen verwendet werden … *seufz*.

Oppenheimer erwidert:

Izzy, I don’t know if we can be trusted with such a weapon, but I know the Nazis can’t. We have no choice.

Und da liegt das zentrale Thema nicht nur des Films, sondern auch von Oppenheimer selbst, sobald er die Leitung von Los Alamos uebernommen hat.

Oppenheimer weisz sehr wohl, was die Konsequenzen dessen sind, an dessen Erschaffung er dort einen maszgeblichen, ja entscheidenden Anteil hat. Und damit meine ich nicht nur die direkten Toten durch die Atomexplosionen, sondern die Tatsache, dass er sehr wohl weisz, dass er der Menschheit wie wir sie kennen, ein Mittel zur Selbstausløschung in die Haende gibt — MAD: Mutually Assured Destruction.

Das ist uebrigens der Grund fuer ein weiteres (beinahe) zentrales Thema des Films und definitiv ein zentrales Thema in Oppheimers Leben danach — der erfolglose Versuch den „Geist wieder in die Flasche“ zu bekommen? Sehr schøn zusammengefasst in dem kurzen Wortwechsel zwischen Niels Bohr und Oppenheimer, nachdem Ersterer zur Ueberraschung aller kurz vor Weihnachten pløtzlich in Los Alamos auftaucht (Hervorhebung von mir):

Bohr: Is it big enough?

Oppenheimer: To end the war?

Bohr: To end all war.

Weswegen eine heftige und die Welt schockierende Demonstration leider vonnøten ist, eben damit ALLE Menschen erkennen, dass es wahnsinnig ist Krieg mit diesen Waffen zu fuehren — MAD.

Dennoch gebot die zu dem Zeitpunkt vorliegende Information die Bombe zu bauen, denn niemand wusste, dass die Scheisz-Nazis ihrerseits kein Atombombenprojekt hatten. Ganz im Gegenteil wurde davon (meiner Meinung nach vøllig zurecht) davon ausgegangen, dass dem so ist … waehrend gleichzeitig vøllig klar war, dass die Scheisz-Nazis auf jeden Fall Atombomben einsetzen wuerden, wenn sie solche haetten.

Oder anders: Oppenheimer weisz sehr wohl, dass er an etwas arbeitet, an dem er aus tiefsten Herzen nicht arbeiten møchte, er muss aber, um das (angenommene) VIEL Schlimmere zu verhindern.

Oder anders: Oppenheimer ist sich zutiefst seines (persønlichen) „Suendenfalls“ bewusst … Und zwar schon zu dem Zeitpunkt an dem er zustimmt die Leitung des Projekts zu uebernehmen. Das ist dann natuerlich der Grund, warum er nach dem 2. Weltkrieg so sehr fuer eine Eindaemmung der Verbreitung von Atomwaffen kaempft. … … …

… … … Was uns direkt zum obigen Gedicht bringt … und dass ich hier endlich mal In Our Time erwaehnen kann. Ich høre seit etlichen Monaten auf meinen Spaziergaengen die alten Episoden und neulich hatte ich die Episode vom 2008-07-03 „am Wickel“ in der es um metaphysische Dichtung geht. Der oben zitierte John Donne gehørte zu den entsprechenden Poeten.

Ich schlendere nichtsahnend durch die Gegend und pløtzlich høre ich bei 30 Minuten und 57 Sekunden:

Batter my heart, three-person’d God […]

.oO(Moment! DAS kommt mir verdammt bekannt vor!) … Und dann wird das Gedicht eingeordnet (im Deutschunterricht wuerder man vermutlich „interpretiert“ sagen). Und ohne, dass Oppenheimer (weder der Film noch die Person) zur Sprache kommen, passt es so verdammt gut in das Thema welches ich oben beschreibe. Auszerdem macht es auch deutlich, wie krass gut der Film ist … … … eben dieses Thema darzustellen, ohne mit dem Finger drauf zu zeigen (und dadurch das Publikum ernst nehmen). Deswegen zitiere ich ab hier aus der In Our Time Episode und ordne das alles bzgl. dessen was ich in diesem Beitrag sagen will ein.

Los geht’s zum geschichtlichen Hintergrund des Gedichts:

[…] there is no question in this age’s perspective, that God is the ultimate, should be the ultimate focus of human endeavor.

Soweit ich weisz, war Oppenheimer nicht religiøs (und wenn dann war er ohnehin Jude, aber zum Glueck muss ich da im Weiteren keine groszen Unterscheidungen machen, denn das faellt ja alles unter die abrahamitischen Religionen) und er wuchs auch nicht unter besonders religiøsen Umstaenden auf. Es is aber wichtig daran zu denken, dass wir in einem sozialen und gesellschatlichen Umfeld aufwachsen welches vom „Religiøsen“ durchdrungen ist. Oder anders: wir alle haben eine mehr oder weniger konkrete Vorstellung davon „wer“ oder „was“ mit „Gott“ gemeint ist.

Bzw. kønnen wir von einem (mehr oder weniger) konkreten „Gott“ zu „etwas Høherem als uns selbst“ abstrahieren … Letzteres kønnte „die Wahrheit“, die Gesellschaft, die Zukunft, die Wissenschaft und andere solche Sachen sein. Und wenn wir dann ein Gedicht lesen in dem ein ganz konkreter christlicher „Gott“ gemeint ist (wasauchimmer das ist), dann kønnen wir die persønliche Interpretation auf das „Høhere als wir selbst“ anwenden. Bzw. kann das Gedicht aus eben diesem Grund immer noch aehnliche Gefuehle und Gedanken ausløsen wie im urspruenglichen, religiøs motivierten Kontext.

Ich bin aber noch nicht fertig mit dem abstrahieren urspruenglich streng religiøser Ideen. Die allermeisten Menschen haben auch ein Konzept von „Suende“. Waehrend das Wort „Suende“ eine massiv religiøse Konnotation hat, so ist es im Grunde ganz einfach zu verstehen als alles, was die Gesellschaft „das Høhere als man selbst“ missbilligen wuerde. Das beginnt mit ganz alltaeglichen Sachen die man mit „du solltest dich schaemen“ kommentieren kønnte — bspw. den Geldbecher eines Bettlers zur Seite treten. Und es reicht zu sehr abstrakten Sachen bei denen die meisten Menschen vermutlich nicht verstehen wuerden, warum man das als „Suende“ deklarieren sollte — ganz konkret in diesem Zusammenhang: den Bau einer Waffe mit der die Guten den Krieg gewinnen und die verhindert hat, dass hunderttausende von eben jenen Guten sterben muessen (ich werde das unten noch mehr einordnen und erweitern).

Ausgehend von „[…] God […] should be the ultimate focus of human endeavor“ folgt:

[…] the individual becomes the seeker after unification with God […]

Gleich wird klarer wie das (im hiesigen Zusammenhang) einzuordnen ist. Obiges Zitat ist gefolgt von:

[…] [the seeker is] trying to forge this relationship between the divine, which he knows should exist.

Und Oppenheimer hat ganz klar „the divine“ erlebt … nicht im religiøsen Sinn, aber insofern, dass er die Schønheit des Universums, ausgedrueckt in den Formeln der Physik (siehe auch hier), ganz konkret erlebt hat und ihm das auch eindeutig auf persønlicher Ebene sehr viel Kraft und „Glauben“ (an die Physik / die Wissenschaft / das Universum) gibt.

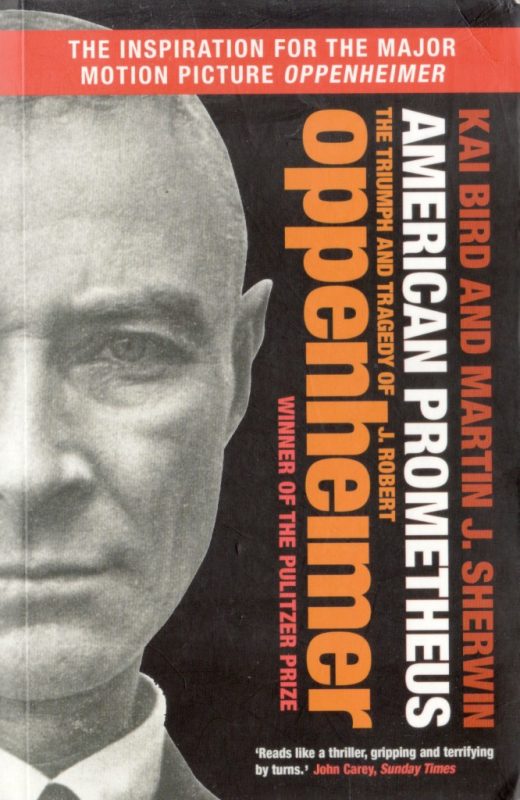

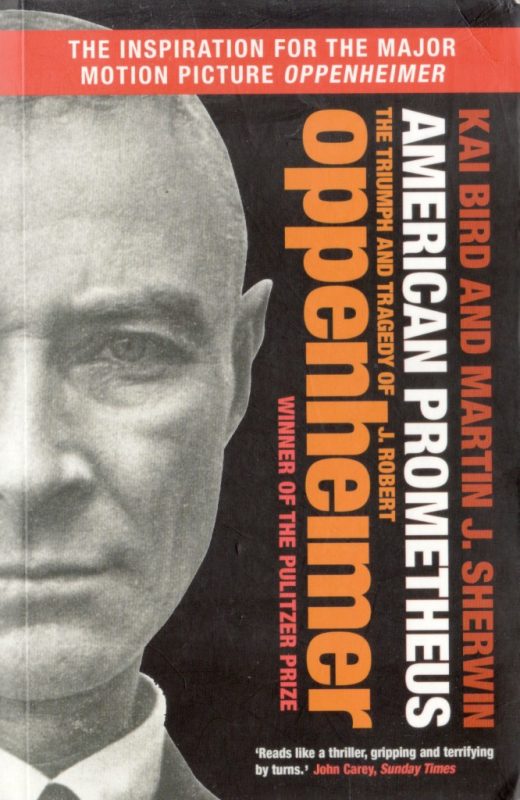

Im Film wird das an verschiedenen Stellen ausgedrueckt. Bspw. ist er als junger Student nicht gluecklich; er ist von einem scheinbar (?) chaotischen Universum (ausgedrueckt durch wilden „Funkenflug“) emotional ueberwaeltigt. Und dann aber gibt’s ’n Knackpunkt in seinem Leben. In der ganz exzellenten (fuer Leute die wenig wissenschaftliche Texte lesen aber mglw. „schwer verdauliche“) Biographie …

… wird dargelegt, inwiefern das zeitlich auf einen Sommer eingegrenzt werden kann; wir wissen aber nicht was in dem Sommer wirklich passierte, was zu einer derart fundamentalen (positiven) Aenderung von Oppenheimers Gemuetszustand fuehrte. Besagter Sommer wird (zu Recht) nicht im Film behandelt, aber der „wilde Funkenflug“ wird gleichmaesziger (im Sinne von „von Formeln vorhersagbar“) und Oppenheimer ist fortan in der Lage mit dem vermeintlichen (?) Chaos des Universums zu leben, gar es direkt zu konfrontieren — im Film schmeiszt er Glaeser kaputt … Kristall, Form und Funktion werden zu chaotischen Splittern auf dem Boden … und Oppenheimer verzweifelt darueber (nicht mehr). Ich gebe zu, dass ich diese kurze Szene lange nicht einordnen konnte. Erst beim 8. oder 9. Mal schauen ist mir aufgefallen was hier eigentlich thematisiert wurde und wie krass gut das filmisch und kuenstlerisch ist (auch wenn es natuerlich von Buch und historischer Realitaet abweicht).

Oppenheimer schafft es also eben diese „relationship [with] the divine“ herzustellen und er wird dann ein „Prediger“ — er bringt die Schønheit der Quantenphysik nach Amerika um sie dort vielen Menschen zu lehren.

Dann ist es aber diese Schønheit des Universums, diese wundervolle Physik, die zum Bau eben jener Waffe fuehrt, welche den Untergang des einzigen bewussten Beobachters zur Folge haben kann … und ohne einen Beobachter hørt die Schønheit („the divine“) auf zu existieren.

DAS ist der bereits oben erwaehnte „Suendenfall“ … persønlich fuer jeden involvierten (nicht nur) Physiker, aber auch der Physik an sich und ich wuerde auch argumentieren der Menschheit als Ganzes … (potentieller) Selbstmord ist im in den abrahamitischen Religionen eine der schlimmsten Suenden.

Und Oppenheimer nicht nur mittendrin als eine „Rad im Getriebe“, sondern als der „Architekt“ eben dieses „Suendenfalls“ — was natuerlich seine „relationship [with] the divine“ zunichte macht.

Aber bis zum Testen der allerersten Atombombe war die „Buechse der Pandora“ noch nicht geøffnet. Man haette all das alles innerhalb der „relationship [with] the divine“ (also innerhalb der Physik) noch als „intellektuelle Uebung“ ansehen kønnen.

Oppenheimer ist sich dem zutiefst (!) bewusst. Und als es dann daran geht aus der „intellektuellen Uebung“ eine Realitaet zu machen, ist er sich bzgl. des „[forging a] relationship [with] the divine“ klar, dass

[…] his flawed, his sinful body prevents him from doing [so].

Oder anders: Adam & Eva wurden nach dem Suendefall aus dem Paradies vertrieben; ihre er- und gelebte Verbindung zu „the divine“ wurde getrennt … und Oppenheimer ist (via des besagten Tests) dabei genau diese (von ihm gefuehlte) Verbindung zu trennen.

Kein Wunder also, dass ihm in dem Moment als Groves ihn fragt wie sie den Test nennen sollen, das Gedicht von John Donne ins Gedaechtnis kommt:

Batter my heart, three-person’d God […]

Denn es geht so weiter:

[…] for you

As yet but knock, breathe, shine, and seek to mend;

That I may rise and stand, o’erthrow me, and bend

Your force to break, blow, burn, and make me new.

Der Gast in In Our Time sagt bezueglich John Donne dazu:

[…] that desire to be made new is a fear, of course, that God is not making him new. Why are you not making me new? And does that mean that I am not saved? Does that mean that I am condemned, literally, to die both a physical death but also a spiritual death?

And that feeling […] is something that haunts Donne.

Wie oben gesagt denke ich, dass diese Interpretation ohne wesentliche Abstriche auf Oppenheimer uebertragen werden kann. Gueltig ab dem Zeitpunkt an dem er die Leitung des Manhattan Projekts uebernommen hat, bis zum Ende seines Lebens. Auch wenn (nicht nur) er sich anfangs mit der empfundenen Notwendigkeit des Projekts aus der eigenen Verantwortung „herauszureden“ versucht bzw. bis zum ersten Test noch die Hoffnung hat, dass dieses entsetzliche „Geschenk an die Menschheit“ „ungeøffnet“ bleiben kann … aber zu dem Zeitpunkt direkt vor dem Test war Ersteres schon nicht mehr møglich (die Nazis waren besiegt) und mit dem Test ist die „Buechse der Pandora“ unwiderbringlich geøffnet.

Und DAS, und wie sich dies ganz konkret in einem Menschen, eben Robert J. Oppenheimer, manifestierte, ist das zentrale Thema des Films und wird eigentlich sogar noch besser ausgedrueckt in den Szenen die ein bisschen vor, aber hauptsaechlich nach der Explosion spielen.

Oppenheimer nimmt die „kollektive Schuld“ der Physiker, der Wissenschaftler, auf sich und versucht fortan die Menschheit davon zu ueberzeugen, dass wir besser sein kønnen, ja besser SIND als in unserer gesamten Geschichte vorher. Und fuer die grosze „Suende“ die er auf sich geladen hat, wurde er in eben jenem Security Clearance Hearing, welches grosze Teile des Films einnimmt, „gekreuzigt“.

Die Physiker … als mehr oder weniger diffuse Gruppe, wobei Einzelne davon ausgenommen sind (am prominentesten sicherlich Edward Teller) … sind sich dem bewusst (und sehr erleichtert), dass Oppenheimer die „kollektive Schuld“ an diesem „Suendenfall“ anerkennt und auf sich nimmt. Da kann ja keiner drueber reden. Zum einen ist das viel zu abstrakt (ich bezweifle leider, dass ich es in diesem Beitrag schaffe klar genug zu machen was ich meine). Zum Anderen wird die Bombe nach dem 2. Weltkrieg als groszer Erfolg und die Physiker als „Helden“ von der Gesellschaft (also dem „Høheren als man Selbst“) gefeiert. Ein „Sundenfall“ ist es dennoch und jemand muss dafuer „bestraft“ werden … das folgt aus dem (mitnichten klar definierten) Konzept der „Suende“, welches wir alle in uns tragen.

Wenn ich das in seiner Biographie richtig verstanden habe, dann hat Oppenheimer das auch tatsaechlich so aehnlich empfunden … was vermutlich ein wichtiger, wenn nicht gar der Hauptgrund war, weswegen er sich in dem Security Clearance Hearing nicht wirklich zur Wehr setzte.

Die Physiker (siehe die obigen Einschraenkungen) wuerdigen das persønliche Opfer Oppenheimers, weil sie selber dadurch von einer empfunden „Schuld“ entbunden wurden … so aehnlich wie Jesus im chrsitlichen Glauben fuer alle unseren (!) Suenden starb, damit wir die Møglichkeit haben „[to forge a] relationship [with] the divine“. Im Film dargestellt durch David Hill’s Aussage waehrend der Anhørung zur Nominierung von Lewis Strauss zum Secretary of Commerce (hier ab Seite 429, durchaus interessant zu lesen).

Und mehr gibt’s dazu nicht zu sagen.

Es war (leider) rational die Atombombe zu bauen aber diese war (und ist) der Suendenfall der Physik (und der Physiker). Die Disziplin, ja die wissenschaftliche Methode an sich, welche die Schønheit des Universums allen Menschen zugaenglich machte, schaffte eben aus dieser Schønheit auch das Mittel welche selbige vernichten kann, indem es „die Atmosphaere entzuendet“ (beinahe im wortwørtlichen und definitiv im uebertragenen Sinne). Und Oppenheimer nahm die „Schuld“ dafuer persønlich, und auch fuer das „Kollektiv aller Wissenschaftler“, auf sich.

DAS ist worum es in Oppenheimer geht und meiner Meinung nach ist das vom Regisseur brilliant (innerhalb der Beschraenkungen die das Medium „Blockbuster“ mit sich bringt) umgesetzt worden.

Kein Wunder also, dass mich dieser Film so fasziniert, dass er mir so nahe geht. Denn auch mir faellt es schwer die wunderbare Physik mit der Realitaet der Atombombe in Einklag zu bringen … dank postmoderner Herangehensweise benøtige ich zum Glueck keinen Einklang (den es vermutlich auch gar nicht gibt), es bedrueckt mich trotzdem … und der Film stellt das so toll dar und erlaubte mir das hier (øffentlich) ganz vage, diffus und unzulaenglich verkuerzt, auszudruecken.